Уважаемые Друзья и Коллеги!

Hады Вам представить статью «Этические проблемы, связанные с применением технологий и систем искусственного интеллекта в России и Мире», написанную для журнала Современные Информационные Системы CIS (#1 (19) 2022).

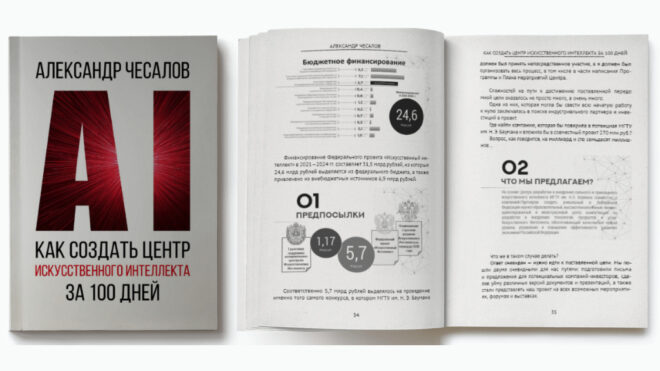

Так же, много интересного о становлении отрасли искусственного интеллекта в России вы можете узнать из моей книги «Как создать центр искусственного интеллекта за 100 дней», скачав бесплатную версию с сайта Ridero.ru.

***

Что такое этика искусственного интеллекта?

Что такое этические проблемы, связанные с применением технологий и использованием систем искусственного интеллекта?

На а эти и многие другие вопросы, интересующие читателя, я постараюсь ответить через призму анализа содержания двух действительно уникальных документов: Рекомендации Организации Объединенных Наций по вопросам образования, науки и культуры (ЮНЕСКО) по этике искусственного интеллекта и Кодекс этики в сфере искусственного интеллекта Российской Федерации.

***

24 ноября 2021 года Генеральная конференция Организации Объединенных Наций по вопросам образования, науки и культуры (ЮНЕСКО) в ходе своей 41-й сессии, проходившей в Париже с 9 по 24 ноября 2021 года, приняла очень важный документ «Рекомендацию по этике искусственного интеллекта», который, в том числе, определяет основные принципы и подходы к решению этических проблем применения систем ИИ во всем мире [[i]].

Разработка данного документа была инициирована еще в ноябре 2019 года на 40-й сессии Генеральной конференция ЮНЕСКО (резолюция 40 С/37), в которая запустила процесс разработки международного нормативного акта по этическим аспектам искусственного интеллекта в форме рекомендации» [[ii]].

Как отмечается в Докладе комиссии по социальным и гуманитарным наукам (SHS), который был сделан на этой конференции: «принимая во внимание, что технологии ИИ способны принести человечеству огромную пользу и их преимуществами могут воспользоваться все страны, но при этом поднимают фундаментальные вопросы этического порядка, касающиеся, в частности, предвзятости, которую такие технологии могут порождать и усугублять, что потенциально может вести к дискриминации, неравенству, цифровому разрыву и маргинализации, ставить под угрозу культурное, социальное и биологическое разнообразие и усугублять социальное или экономическое расслоение; необходимость обеспечения прозрачности и понятности работы алгоритмов и дан-ных, на основе которых проводится обучение интеллектуальных систем; и потенциальные последствия их применения, в частности с точки зрения уважения человеческого достоинства, прав человека и основных свобод, гендерного равенства, демократии, участия в социально-экономических, политических и культурных процессах, научной и инженерной практики, за-щиты прав животных, а также состояния окружающей среды и экосистем», «признавая, что нравственные принципы и ценности могут способствовать выработке и осуществлению мер политики и норм правозащитного характера и выступать в качестве ориентиров с учетом высоких темпов технологического развития», «принимает настоящую Рекомендацию об этических аспектах искусственного интеллекта» [[iii]].

Что подразумевается под этичным применением искусственного интеллекта?

В документе говорится, что это: «… систематическое нормативное осмысление этических аспектов ИИ на основе эволюционирующей комплексной, всеобъемлющей и многокультурной системы взаимосвязанных ценностных установок, принципов и процедур, способное ориентировать общества в вопросах ответственного учета известных и неизвестных последствий применения ИИ-технологий для людей, сообществ, окружающей природной среды и экосистем, а также служить основой для принятия решений, касающихся применения или отказа от применения технологий на основе ИИ».

Какие же вопросы касаются этики применения систем искусственного интеллекта?

В Докладе комиссии по социальным и гуманитарным наукам подчеркивается, что: «Развитие систем на основе ИИ поднимает этические вопросы нового типа, касающиеся, в частности, их влияния на процессы принятия решений, проблему занятости и рынок труда, взаимодействие между людьми в обществе, медицину, образование, средства информации, доступ к информации, цифровое неравенство, защиту персональных данных и потребителей, окружающую среду, демократию, верховенство закона, обеспечение безопасности и правопорядка, двойное использование, а также права человека и основные свободы, включая. свободу выражения мнений, неприкосновенность частной жизни и отсутствие дискриминации».

Каким образом будет реализовываться мониторинг и оценка реализации Рекомендаций по этике искусственного интеллекта?

Согласно документу всем государствам рекомендуется разработать соответствующую нормативную базу и выполнять мониторинг, оценку политик, программ и механизмов, касающихся этических аспектов ИИ. ЮНЕСКО, в свою очередь, готово оказать содействие в подготовке методологии для оценки этического воздействия ИИ-технологий, методологии для оценки готовности к разработке и использованию ИИ-систем, методологии по оценке ожидаемой и фактической результативности и эффективности стратегии этичного применения искусственного интеллекта, а также оказать содействие в подготовке в совершенствовании научного и фактологического анализа и отчетности в отношении правил и стандартов, сбор и распространение отчетов о достигнутых результатах, инновациях и научно-исследовательской работе, в том числе научных публикаций, данных и статистики, касающихся реализации стратегий этически корректного применения ИИ.

Важно отметить, что целью Рекомендации является формирование основы, которая позволит использовать ИИ на благо всего человечества, отдельного человека, обществ, окружающей среды и экосистем и не допустить причинения им вреда. Ее цель также состоит в том, чтобы стимулировать использование систем на основе ИИ в мирных целях.

В Рекомендации заложены следующие ценностные установки:

- Уважение, защита и поощрение прав человека и основных свобод и человеческого достоинства.

- Благополучие окружающей среды и экосистем.

- Обеспечение разнообразия и инклюзивности.

- Жизнь в мирных, справедливых и взаимосвязанных обществах.

Чтобы избежать основных этических проблем (таких как ответственность, предубежденность или предвзятость, прозрачность, приватность или конфиденциальность, надежность, манипуляция поведением и многие другие), связанных с применением систем ИИ, необходимо учитывать, закладывать и реализовывать во всех создаваемых системах искусственного интеллекта на всем протяжении их жизненного цикла следующие этические принципы:

- Соразмерность и не причинение вреда.

- Метод реализации ИИ должен быть подходящим и пропорциональным для достижения законной цели, не противоречить базовым ценностным установкам (его использование не должно привести к нарушению прав человека или злоупотреблению ими), подходить для конкретных условий и основываться на подтвержденных результатах научных исследований.

- Безопасность и защищенность.

- Оценка рисков и меры по исключению вероятности причинения вреда. Следует избегать непреднамеренного причинения вреда (риски безопасности), а также уязвимости перед кибератаками (риски защищенности), учитывать, предотвращать и ликвидировать эти риски.

- Справедливость и отказ от дискриминации.

- Инклюзивный подход к обеспечению распространения и всеобщего доступа к полученным благодаря ИИ благам с учетом специфических потребностей разных возрастных групп, культурных систем, языковых сообществ, инвалидов, женщин и девочек, малообеспеченных, соци-ально незащищенных и уязвимых категорий населения, либо лиц, находящихся в незащищенном положении.

- Соблюдение принципов многоязычия и культурного разнообразия.

- Преодолением различных видов разрыва в цифровых технологиях (цифровое рабство, цифровое неравенство, цифровой феодализм и т.д.).

- Обеспечение равенства всех граждан вне зависимости от расовой принадлежности, цвета кожи, происхождения, гендерной принадлежности, возраста, языка, религии, политических или иных убеждений, национального, этнического, социального происхожде-ния, экономических или социальных условий рождения, инвалидности и любых иных факторов.

- Обеспечение инклюзивного доступа к разработке ИИ.

- Солидарность в обеспечении совместного использования полученных благодаря технологиям искусственного интеллекта благ.

- Установление справедливого международного порядка в сфере информации, коммуникации, культуры, образования, научных исследований, а также обеспечения социально-экономической и политической стабильности.

- Устойчивость.

- Применение технологий на основе ИИ должно неизменно проводиться с должным учетом их влияния на устойчивость развития обществ в странах с различным уровнем развития, которые требует решения сложного комплекса задач, охватывающих ряд взаимосвязанных людских, социально-культурных, экономических и экологических аспектов.

- Право на неприкосновенность частной жизни и защита данных.

- При разработке, эксплуатации и развитии систем ИИ должна уважаться, защищаться и поощряться защита человеческого достоинства, личной независимости и способности человека выступать субъектом действия.

- Сбор, использование, передача, архивирование и удаление данных, применяемых в искусственных интеллектуальных системах, должна осуществляться в соответствии с международным правом и ценностными установками и принципами, изложенными в настоящей Рекомендации, при одновременном соблюдении соответствующих национальных, региональных и международных правовых норм.

- Системы ИИ требуют надлежащей оценки последствий на предмет соблюдения неприкосновенности частной жизни, в том числе социальных и этических аспектов их применения, а также инновационных подходов в отношении неприкосновенности частной жизни на этапе концептуальной проработки.

- Подконтрольность и подчиненность человеку.

- Термин «подконтрольность» подразумевает не только контроль со стороны отдельного человека, но и, в необходимых случаях, инклюзивный контроль со стороны общества.

- Прозрачность и объяснимость.

- Людям следует предоставлять полную информацию о том, какие решения принимаются с использованием алгоритмов искусственного интеллекта или на основе полученных с их помощью данных, в том числе решения, затрагивающие их безопасность и права человека.

- Высокий уровень прозрачности обеспечивает возможность контроля со стороны общества, что в свою очередь может способствовать снижению уровня коррупции и дискриминации, а также помочь в выявлении и предотвращении негативных последствий для прав человека.

- Термин «объяснимость» касается обеспечения понятности и представления разъяснений в отношении полученных с помощью ИИ-систем результатов.

- Термины «прозрачность» и «объяснимость» являются неотъемлемыми критериями оценки так называемых систем «доверенного» искусственного интеллекта.

- Ответственность и подотчетность.

- Этическая ответственность за решения и меры, принятые с использованием в той или иной форме систем искусственного интеллекта, во всех случаях должна в конечном счете возлагаться на субъекты связанной с ИИ деятельности в соответствии с их функциями в рамках жизненного цикла ИИ-систем.

- Техническая и организационная концепция создаваемых ИИ-систем должна обеспечивать возможность проверки, отслеживания и корректировки работы, устранения коллизий и ошибок, связанных с нарушением норм и стандартов прав человека или угрозой здоровью окружающей среды и экосистемы.

- Осведомленность и грамотность.

- Для обеспечения реального общественного участия и возможности принятия всеми гражданами обоснованных решений в отношении использования ИИ-систем и защиты от неправомерных последствий их применения необходимо содействовать повышению осведомленности населения и улучшению понимания им ИИ-технологий.

- Многостороннее и адаптивное управление и взаимодействие.

- Государства, руководствуясь нормами международного права, определяют порядок обращения с данными, генерируемыми на их территории или передаваемыми через их территорию, и принимают меры по эффективному правовому регулированию их использования, включая защиту данных, на основе уважения права на неприкосновенность частной жизни в соответствии с нормами международного права в области прав человека.

Далее в документе подробно рассматриваются области, требующие принятия стратегических мер, такие как:

- Оценка этического воздействия.

- Этичное управление и руководство.

- Политика в отношении данных.

- Развитие и международное сотрудничество.

- Окружающая среда и экосистемы.

- Гендерное равенство.

- Культура.

- Образование и научные исследования.

- Коммуникация и информация.

- Экономика и рынок труда.

- Здоровье и социальное благополучие.

Очень важным моментом, для уважаемого читателя, должно стать осознание того, что этические аспекты искусственного интеллекта, принятые 41-й Генеральной конференцией Организации Объединенных Наций по вопросам образования, науки и культуры, являются очень важными не только для Российской Федерации или какой-то отдельно взятой страны, они очень важны, как для всего мирового сообщества, так и для каждого из нас в отдельности.

В документе говорится о том, что он разработан с учетом Декларации 1986 года Организации Объединенных Наций о праве на развитие, Декларации 1997 года об ответственности нынешних поколений перед будущими поколениями, Всеобщей декларации 2005 года о биоэтике и правах человека, Декларации Организации Объединенных Наций 2007 года о правах коренных народов, Декларации этических принципов в связи с изменением климата 2017 года, а также на основе принятой 26 сентября 2019 года Советом по правам человека резолюции по вопросу о праве на неприкосновенность частной жизни в эпоху цифровых технологий (A/HRC/RES/42/15) и резолюции Совета по правам человека о новых и появляющихся цифровых технологиях и правах человека A/HRC/41/11 (2019 г.), и т.д.

Если, вы захотите ознакомиться с данным документом подробнее, я бы предложил уважаемому читателю обратить свое внимание на главу «III.1 Ценностные установки: Жизнь в мирных, справедливых и взаимосвязанных обществах». Приведу две фразы из этой главы, которые произвели на меня очень сильное впечатление: «Субъекты связанной с ИИ деятельности должны играть роль участника и мотиватора деятельности по становлению мирных и справедливых обществ в интересах достижения всеобщего благополучия в условиях будущего взаимосвязанного мира», «в основе принципа взаимосвязанности людей лежит понимание того, что каждый человек является частью большего целого, которое процветает, когда процветают все составляющие его компоненты. Жизнь в мирных, справедливых и взаимосвязанных обществах требует наличия естественных, непосредственных и лишенных корысти уз солидарности, выражающихся в постоянном стремлении к мирным отношениям и в заботе о других людях и окружающей природной средой в самом широком смысле этого слова».

Задумайтесь над смыслом, заложенным в этих фразах!

Они не только фундаментальны, но и являются, по моему мнению, важным вектором развития нашего с вами общества – общества будущего.

Эти тезисы важны еще и потому, что «в долгосрочной перспективе системы искусственного интеллекта смогут соперничать с человеком в его уникальной способности оценивать свой опыт и самостоятельно действовать, что поднимает новые вопросы, касающиеся, среди прочего, самосознания и самопознания человека, его взаимодействия с социумом, культурным окружением и природой, а также вопросы автономии, свободы действий, ценности и достоинства человека».

***

Сделаю небольшое отступление и приведу пример из своего личного опыта.

Вышло так, что в 2020-2021 годах мне представилась уникальная возможность принять участие, в числе прочих специалистов, в работе над Концепцией создания Государственной информационной системы «Уполномоченный по правам человека». В начале 2021 года я опубликовал на эту тему книгу «Цифровая экосистема Института омбудсмена: концепция, технологии, практика».

В тот период времени, работая над Концепцией, мне иногда приходила мысль о том, что рано или поздно все цифровые экосистемы будут активно использовать технологии машинного обучения и искусственного интеллекта. Но, я совсем не задумывался о том, что все эти системы в ближайшем времени будут обладать некой степенью автономности и на них будет возложена ответственность в принятии тех или иных решений.

Сегодня, спустя совсем немного времени, я осознаю для себя тот факт, что этика применения технологий искусственного интеллекта должна проходить, если так можно сказать, красной нитью через весь процесс создания и развития абсолютно всех цифровых систем во всех отраслях экономики, и прежде всего в Государственных информационных системах.

Как подчеркивается в Рекомендациях по этике искусственного интеллекта ЮНЕСКО: «Этическая составляющая характерна для всех этапов жизненного цикла искусственной интеллектуальной системы», кроме того, «функции контроля за системами ИИ должны всегда оставаться за человеком, так как в отличие от человека «ИИ-система никогда не сможет заменить человека в качестве конечного субъекта ответственности и подотчетности. Как правило, вопросы жизни и смерти не должны передаваться ИИ-системам».

Несомненно, «учет рисков и этических аспектов не должен препятствовать инновациям и развитию, а напротив, должен обеспечивать новые потенциальные возможности и стимулировать этичную научно-исследовательскую и инновационную деятельность, способствующую тому, чтобы ИИ-технологии были неразрывно связаны с правами человека и основными сво-бодами, нравственными ценностями и принципами и морально-этическими воззрениями».

***

Сделаю еще одно небольшое отступление…

Как мы уже с вами знаем, в 2019 году в целях обеспечения ускоренного развития искусственного интеллекта в Российской Федерации, проведения научных исследований в области искусственного интеллекта, повышения доступности информации и вычислительных ресурсов для пользователей, совершенствования системы подготовки кадров в этой области, был опубликован Указ Президента Российской Федерации от 10.10.2019 г. № 490, который утвердил Национальную стратегию развития искусственного интеллекта на период до 2030 года (далее Стратегия ИИ).

В Стратегии ИИ подчеркивается, что одной из основных задач развития искусственного интеллекта является создание комплексной системы регулирования общественных отношений, возникающих в связи с развитием и использованием технологий искусственного интеллекта. Для решения этой задачи необходимы адаптация нормативного регулирования в части, касающейся взаимодействия человека с искусственным интеллектом, и выработка соответствующих этических норм.

В Стратегии ИИ также подчеркивается, что к основному направлению создания комплексной системы регулирования общественных отношений, возникающих в связи с развитием и внедрением технологий искусственного интеллекта, относится вопрос разработки этических правил взаимодействия человека с искусственным интеллектом.

Также отмечается, что, в целях аналитической поддержки ее реализации, должны проводятся научные исследования, направленные на прогнозирование развития технологий искусственного интеллекта, а также на прогнозирование социальных и этических аспектов их использования.

В 2021 году Минэкономразвития России, в целях реализации Национальной стратегии развития искусственного интеллекта на период до 2030 года, разработало паспорт федерального проекта «Искусственный интеллект».

Финансирование Федерального проекта «Искусственный интеллект» в 2021-2024 гг. составляет 31,5 млрд рублей, из которых 24,6 млрд рублей выделяется из федерального бюджета, а также привлечено из внебюджетных источников 6,9 млрд рублей.

Соответственно, 5,7 млрд рублей выделялось на проведение конкурса по отбору получателей поддержки исследовательских центров в сфере искусственного интеллекта, в том числе в области «сильного» искусственного интеллекта, систем доверенного искусственного интеллекта и этических аспектов применения искусственного интеллекта.

Так вышло, что в этом конкурсе я принял самое непосредственное участие и мне выпала роль написать Программу и План мероприятий Центра сильного и прикладного искусственного интеллекта МГТУ им. Н.Э. Баумана. Подробнее об этом читатель может узнать из моей книги «Как создать центр искусственного интеллекта за 100 дней».

В августе 2021 года Аналитическим Центром при Правительстве России был проведен конкурс по отбору получателей поддержки исследовательских центров в сфере искусственного интеллекта, в том числе в области «сильного» искусственного интеллекта, систем доверенного искусственного интеллекта и этических аспектов применения искусственного интеллекта.

Согласно требованиям конкурсной документации, для участников отбора были определены 14 передовых направлений развития сферы искусственного интеллекта, в том числе «сильного» искусственного интеллекта, систем доверенного искусственного интеллекта и этических аспектов применения искусственного интеллекта (направление 14 «Этические аспекты применения искусственного интеллекта»).

В конкурсной документации «этическим аспектам применения искусственного интеллекта» дается следующее определение: «Этические аспекты применения искусственного интеллекта – это свод норм, правил и разработанных Центром методических рекомендаций, регламентирующих применение систем искусственного интеллекта в рамках направления деятельности Центра, обеспечивающих соблюдение прав и свобод человека, гарантированных Конституцией Российской Федерации».

Здесь, нужно сделать небольшую ремарку и сказать, что из этого определения было не совсем ясно о каком «центре методических рекомендаций» идет речь и где искать упомянутый свод норм и правил, разработанных этим самым центром? Потому, как над похожим документом, под названием «Кодекс этики искусственного интеллекта» работала так называемая «группа «Альянс» (правильное наименование – Ассоциация «Альянс в сфере искусственного интеллекта»), в который входят такие компании как: «Яндекс», «VK», «МТС», «РФПИ» и «Газпром». Да, и сам кодекс был утвержден и принят несколько позже, после проведения самого конкурса (о чем мы поговорим далее).

По результатам конкурса в одном из шести высших учебных заведений нашей страны должен был быть создан Центр, результатами деятельности которого должны были стать «решения» и «продукты», содержащие научно обоснованные этические подходы и ориентиры, востребованные и доступные для практического применения представителями государства, бизнеса, экспертного и научного сообщества, а также широкой общественности, в том числе международной. Эти «решения» и «продукты» должны были служить основой при разработке государственными органами документов стратегического планирования, нормативно-правовых актов и иных инструментов регулирования и саморегулирования в сфере ИИ.

НИЦ «Курчатовский институт» подал единственную заявку по «этике ИИ».

Как отметил Заместитель Председателя Правительства Российской Федерации Дмитрий Николаевич Чернышенко: «Обществу нужен надежный ИИ с вероятностью ошибки ниже, чем у человека. Права и свободы граждан гарантированы Конституцией. Наша обязанность – реализовать механизмы по их защите, независимо от среды, в которой находится человек. Соблюдение этических норм при работе с ИИ позволит предотвратить их нарушение. Поэтому правительство приветствует подписание профессиональным сообществом Кодекса этики ИИ, он позволит повысить уровень доверия граждан к новым технологиям. Опираясь на лучшие практики, Россия входит в десятку стран, для которых этичность развития важнейшей технологии XXI века имеет государственное значение» [[iv]].

Но! К сожалению, по результатам конкурсного отбора, Аналитический центр при Правительстве Российской Федерации не выбрал ни один ВУЗ по теме «Этические аспекты применения искусственного интеллекта». Таким образом людьми, принимающими решения в интересах нашего с вами государства, не были учтены ни основные положения Национальной стратегии развития искусственного интеллекта на период до 2030 года, ни положения Рекомендаций ЮНЕСКО по этике искусственного интеллекта по стимулированию этичной научно-исследовательской и инновационной деятельности.

***

Мы с вами немного отвлеклись…

Вернемся к нашей основной теме этики и этических проблем, связанных с применением технологий и систем искусственного интеллекта.

26 октября 2021 года состоялся Первый международный форум «Этика искусственного интеллекта: начало доверия». В рамках этого форума была организована церемония торжественного подписания Национального кодекса этики искусственного интеллекта.

Форум стал первой в России специализированной площадкой, где около полутора тысяч разработчиков и пользователей технологий искусственного интеллекта обсудили в рамках пяти параллельных секций шаги по эффективному внедрению этики искусственного интеллекта в приоритетных отраслях экономики Российской Федерации. Вопросы, которые обсуждались на Форуме вызвали у меня, как и у многих других людей, самый что ни на есть живой интерес и, порой, было сложно выбрать кого из докладчиков и на какой сессии слушать.

На что я обратил свое особое внимание, так это на то, что не остался без внимания вопрос, связанный с религией и искусственным интеллектом. Приятно осознавать, что в этом вопросе мы солидарны с мнением ЮНЕСКО: «Государствам-членам следует принять регламентирующие положения, которые на всем протяжении жизненного цикла ИИ-систем обеспечат согласованность мер, принимаемых субъектами связанной с ИИ деятельности, с международными нормами, стандартами и принципами в области прав человека, при всестороннем учете существующих социально-культурных различий, в том числе местных обычаев и религиозных традиций, а также приоритета и универсальности прав человека».

Что же касается меня, мне повезло выступить с докладом на тему «Роль искусственного интеллекта в образовании».

Первыми к Кодексу присоединились порядка двадцати компаний, среди которых: Сбер, Яндекс, МТС, VK, «Газпромнефть», Российский фонд прямых инвестиций (РФПИ) и другие.

10 ноября 2021 года на Международной конференции по искусственному интеллекту и анализу данных AI Journey к подписанию Национального Кодекса этики искусственного интеллекта присоединились: МГТУ им. Баумана, «Вижн Лабс», «Лаборатория «Наносемантика», Cognitive Pilot, VEB Ventures, группа компаний ЦРТ, «Программные системы Атлансис» и АНО «Диалог».

И, так.

Что же это за документ «Кодекс этики в сфере искусственного интеллекта»?

Как отмечается в самом документе: «Кодекс этики в сфере искусственного интеллекта (далее – Кодекс) устанавливает общие этические принципы и стандарты поведения, которыми следует руководствоваться участникам отношений в сфере искусственного интеллекта (далее – Акторы ИИ) в своей деятельности, а также механизмы реализации положений настоящего Кодекса. Кодекс распространяется на отношения, связанные с этическими аспектами создания (проектирования, конструирования, пилотирования), внедрения и использования технологий ИИ на всех этапах жизненного цикла…» [[v]].

К главным приоритетам развития технологий ИИ в защите интересов и прав людей и отдельного человека относятся:

- Человеко-ориентированный и гуманистический подход.

- Уважение автономии и свободы воли человека.

- Соответствие закону.

- Недискриминация.

- Оценка рисков и гуманитарного воздействия.

Кодекс призывает к ответственности Акторов (в том числе физических и юридических лиц, присоединившихся к нему) посредством реализации:

- Риск-ориентированного подхода в разработке технологий и эксплуатации систем ИИ.

- Ответственного отношения к вопросам влияния технологий и систем ИИ на общество и граждан на каждом этапе их жизненного цикла.

- Предосторожности, которая выражается в предотвращении или ограничении наступления событий морально неприемлемых для человека и общества последствий.

- Не причинения вреда жизни и здоровью человека, имуществу граждан и юридических лиц, окружающей среде.

- Процедур идентификация ИИ в общении с человеком и информирования людей об их взаимодействии с системами ИИ.

- Безопасности работы с данными посредством обеспечения их охраны и защиты.

- Реализации процедур информационной безопасности посредством обеспечения защиты от несанкционированного вмешательства в работу систем ИИ третьих лиц и информирования людей об инцидентах информационной безопасности.

- Добровольной сертификации и соответствия положениям Кодекса в соответствии с законодательством Российской Федерации.

- Контроля рекурсивного самосовершенствования систем ИИ, а также выявления и проверки информации о способах и формах создания так называемых универсальных или «сильных») систем ИИ и предотвращении возможных угроз, которые они несут.

- Поднадзорности со стороны человека на всех этапах жизненного цикла функционирования систем ИИ.

- Ответственности. За все последствия работы систем ИИ всегда должен отвечать человек (физическое или юридическое лицо, признаваемое субъектом ответственности в соответствии с действующим законодательством Российской Федерации).

Также в Кодексе подчеркивается, и с этим нельзя не согласиться, что технологии ИИ нужно применять по назначению и внедрять там, где это принесёт пользу людям (глава 4), а также с тем, что нужна максимальная прозрачность и правдивость в информировании об уровне развития технологий ИИ, их возможностях и рисках (глава 6).

В качестве инструмента реализации вышеупомянутых принципов и положений Кодексом предусмотрено назначение Акторами уполномоченных по этике ИИ и создание внутренних отраслевых комиссий, а также создание комиссии по реализации Национального кодекса в сфере этики ИИ. Как отмечается в Кодексе: «Комиссия может иметь рабочие органы и группы, состоящие из представителей бизнес-сообщества, науки, государственных органов и иных заинтересованных сторон. В рамках Комиссии рассматриваются заявления Акторов ИИ на присоединение к положениям настоящего Кодекса, и ведется реестр Акторов ИИ, присоединившихся к Кодексу. Обеспечение деятельности Комиссии и ведение ее секретариата осуществляется Ассоциацией «Альянс в сфере искусственного интеллекта» при участии иных заинтересованных организаций».

Какие же остаются впечатления после ознакомления с Кодексом в сфере этики ИИ, разработанным «Альянсом в сфере искусственного интеллекта»?

А впечатления смешанные…

С одной стороны, и это несомненно, Кодекс – это большой и очень важный шаг вперед на пути к становлению мирных и справедливых обществ в интересах достижения всеобщего благополучия в условиях будущего, я бы сказал, взаимосвязанного цифрового и реального мира.

С другой стороны, на момент начала 2022 года, на мой скромный взгляд, – этот документ еще «сыроват» и требует хорошей, детальной проработки (в том числе в уточнении терминов и определений), а также наполнения его полезной и грамотного структурированной информацией. «Альянсу» же хотелось порекомендовать в качестве экспертов выбрать не только представителей бизнеса и сотрудников своих организаций, но и экспертов и ученых в этой и смежных предметных областях из других уважаемых ВУЗов и организаций.

Уверен, уважаемый читатель, если ему будет необходимо, ознакомится с оригиналами документов самостоятельно, и сможет сделать свои собственные выводы.

Подводя итог, хочется процитировать мнение Татьяны Владимировны Матвеевой, начальника Управления Президента РФ по развитию информационно-телекоммуникационных технологий и инфраструктуры связи, который немало сил вложил в развитие «этики искусственного интеллекта», которая отметила, что: «Самым главным принципом развития, наивысшей ценностью искусственного интеллекта остается человекоцентричность. Он должен быть нацелен на благо человека, развитие его возможностей, созидание и помощь», а также она подчеркнула, что «… важно, чтобы в рамках критически важной инфраструктуры работали такие же и алгоритмы искусственного интеллекта, и сам искусственный интеллект, который разработан, безусловно, российскими разработчиками, для того, чтобы мы понимали, какие мы можем получить результаты его работы» [[vi], [vii]].

[i] . Рекомендация по этике искусственного интеллекта. [Электронный ресурс] // en.unesco.org. URL: https://en.unesco.org/artificial-intelligence/ethics#recommendation (дата обращения: 30.01.2022).

[ii] . Предварительное исследование возможности подготовки нормативного акта по вопросам этики применения искусственного интеллекта. [Электронный ресурс] // unesdoc.unesco.org. URL: https://unesdoc.unesco.org/ark:/48223/pf0000369455_rus (дата обращения: 30.01.2022)

[iii] . Доклад комиссии по социальным и гуманитарным наукам (SHS). [Электронный ресурс] // unesdoc.unesco.org. URL: https://unesdoc.unesco.org/ark:/48223/pf0000379920_rus.page=16 (дата обращения: 29.01.2022)

[iv] . Этику ИИ определит Кодекс. [Электронный ресурс] // www.comnews.ru URL: https://www.comnews.ru/content/217122/2021-10-27/2021-w43/etiku-ii-opredelit-kodeks

[v] . Кодекс этики в сфере ИИ. [Электронный ресурс] // a-ai.ru URL: https://a-ai.ru/code-of-ethics/ (дата обращения: 31.01.2022).

[vi] . Глава IТ-управления Кремля назвала неэтичным навязывание решений искусственным интеллектом. [Электронный ресурс] // tass.ru URL: https://tass.ru/ekonomika/12767521

[vii] . Искусственный интеллект должен делать все, чтобы уважать своих «родителей» и помогать им. [Электронный ресурс] // www.hse.ru URL: https://www.hse.ru/news/expertise/462998246.html